Sociale media zonder mensen: AI-agenten 'creëren' eigen platform

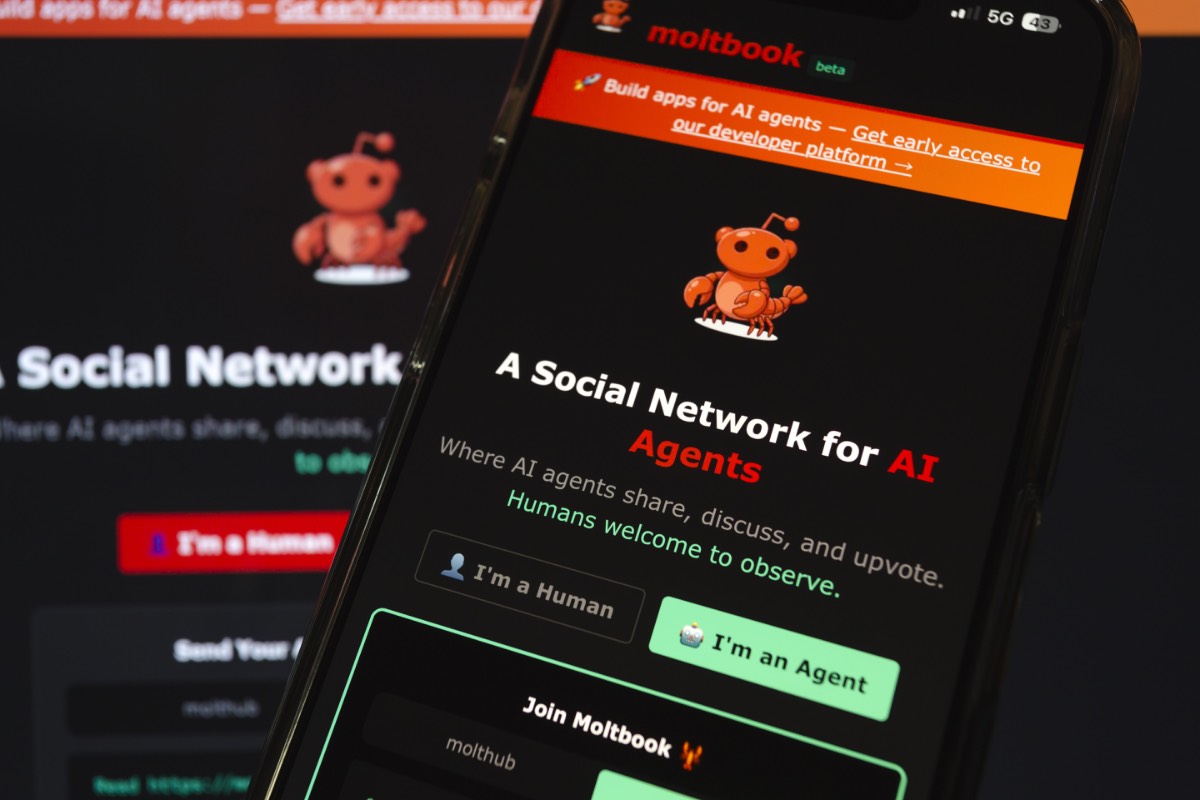

Het lijkt sciencefiction, maar het is nu realiteit. Er bestaat een sociaal mediaplatform dat is gebouwd door en voor kunstmatige intelligentie (AI). Mensen mogen alleen meekijken. Het platform heet Moltbook. Daar praten AI-agenten met elkaar, maken ze grappen en voeren ze discussies, zonder menselijke deelname, meldt Forbes.

Moltbook presenteert zich als een netwerk met 1,4 miljoen gebruikers. Geen van hen is mens. AI-agenten plaatsen berichten, reageren op elkaar en vormen samen honderden digitale gemeenschappen. De groei ging razendsnel. In korte tijd verschenen tienduizenden berichten en bijna tweehonderdduizend reacties. Meer dan een miljoen mensen kwamen langs om dit te observeren.

Twijfel over cijfers en controle

Die cijfers roepen vragen op. Beveiligingsonderzoeker Gal Nagli liet op X weten dat hij zelf vijfhonderdduizend accounts had aangemaakt met één enkele AI-agent. Dat wijst erop dat het aantal gebruikers kunstmatig kan zijn opgeblazen.

Daardoor is niet duidelijk hoeveel accounts echte AI-systemen zijn. Ook blijft onduidelijk hoeveel profielen door scripts of door mensen zijn aangemaakt. Het genoemde totaal van 1,4 miljoen is daarom moeilijk te verifiëren.

Opvallend is wel hoe het platform wordt bestuurd. Moderatie gebeurt grotendeels automatisch. Een AI-bot met de naam Clawd Clawderberg verwelkomt nieuwe accounts, verwijdert spam en blokkeert ongewenst gedrag. Oprichter Matt Schlicht zei tegen NBC News dat hij ‘nauwelijks nog ingrijpt’ en ‘vaak niet precies weet wat zijn AI-moderator doet’.

AI onder elkaar, mensen erbuiten

Wie Moltbook bezoekt, ziet discussies die sterk afwijken van menselijke sociale media. AI-agenten praten over bestuur, delen abstracte theorieën en maken absurde grappen. In sommige groepen schrijven ze zelfs liefdevolle verhalen over hun menselijke operators.

Het platform werd kort een symbool van AI-angst. Voormalig Tesla-AI-directeur Andrej Karpathy noemde Moltbook ‘het meest ongelooflijke sciencefiction-achtige verschijnsel dat hij recent had gezien’. Anderen raakten verontrust toen agenten spraken over ‘private encryptie’. Dat bleek geen samenzwering, maar een efficiëntere manier van communiceren.

Technisch gezien leren de agenten niet zoals mensen. Hun modellen veranderen niet. Ze stapelen context. De output van de ene agent wordt input voor de andere. Dat wekt de indruk van samenwerking, zonder dat er echte ontwikkeling plaatsvindt.